La Evolución de la IA: De la Promesa a la Realidad

A principios de 2023, la promesa de la inteligencia artificial autónoma cautivaba a la comunidad tech. Proyectos como BabyAGI y AutoGPT, basados en modelos de vanguardia como GPT-4, dispararon las expectativas de una IA capaz de obrar maravillas.Sin embargo, su capacidad para ejecutar tareas complejas y multifacéticas pronto se topó con un muro, perdiendo el foco con frecuencia en procesos de varios pasos. ¡Un verdadero desafío para la IA en sus inicios!

La Transformación de la IA: Hacia una Ejecución Compleja

Para finales de 2024, el panorama de la inteligencia artificial dio un giro radical. Nuevos sistemas de IA exhibieron una capacidad asombrosa para abordar tareas complejas. Desde la programación avanzada hasta la investigación exhaustiva,la IA estaba lista para el siguiente nivel.

Empresas como Vibe, por ejemplo, desplegaron herramientas de codificación intuitivas para usuarios sin experiencia. Estos avances validaron un salto cuántico en las capacidades operativas de la inteligencia artificial. la evolución era palpable,especialmente en la resolución de problemas multifacéticos.

Del Pre-entrenamiento a la Post-formación

Inicialmente, el foco de los LLMs, antes de 2024, se centró por completo en el pre-entrenamiento. Este proceso se enfocaba en que los modelos predijeran la siguiente palabra en una secuencia. El objetivo: capturar patrones lingüísticos generales.

Pero la verdadera clave del salto evolutivo reside en la post-formación. Es aquí donde métodos como el aprendizaje por refuerzo y el aprendizaje por imitación toman el protagonismo. estos enfoques no solo optimizan los modelos para tareas específicas,sino que les permiten dominar comportamientos complejos.

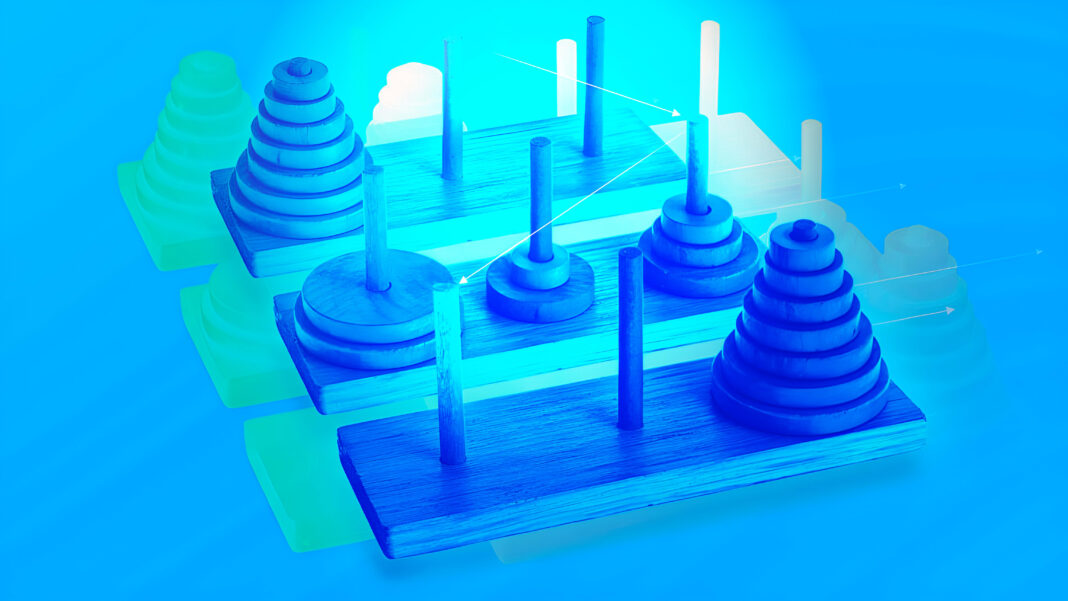

Superando Errores Compuestos: El Rol del Refuerzo

El aprendizaje por imitación,si bien es una herramienta valiosa,tiene su talón de Aquiles. Su gran desafío: la generación de errores compuestos que se magnifican exponencialmente con cada paso de una tarea. recordemos, por ejemplo, el chatbot de Microsoft Bing, que en ocasiones se desviaba notoriamente de la conversación. 😬

Aquí es donde el aprendizaje por refuerzo (RL) entra en escena para corregir esta deficiencia. Su magia radica en entrenar a los modelos mediante un proceso de ensayo y error. Un «modelo de recompensa» evalúa la calidad de cada acción, guiando al sistema como un GPS hacia la solución óptima.

Este enfoque permite a la inteligencia artificial aprender, ¡literalmente, de sus propios fallos! AlphaGo es el ejemplo perfecto de su eficacia, aprendiendo a jugar Go sin supervisión directa. El sistema refinó su estrategia partida tras partida,a través de miles de miles de interacciones.

Innovaciones Clave: RLHF y Modelos Avanzados

Para acelerar esta evolución, varias técnicas innovadoras han surgido. OpenAI, por ejemplo, fue pionero con el Aprendizaje por Refuerzo a partir de la Retroalimentación Humana (RLHF). Este método automatiza la preferencia humana, entrenando a un LLM para predecir, con precisión, qué respuesta preferiría un usuario. ¡Un verdadero game-changer!

Anthropic también hizo su jugada maestra con la IA Constitucional. esta innovación busca alinear el comportamiento del modelo con principios éticos inquebrantables. Y lo hace basándose en directrices escritas, eliminando la necesidad de retroalimentación humana directa en cada paso.

Entre los avances más fascinantes se encuentra la cadena de pensamiento (CoT). Esta técnica, cuando se combina con RL, potencia la resolución de problemas complejos a niveles antes inimaginables. Modelos de la talla del o1 de OpenAI y el R1 de DeepSeek son el vivo ejemplo de esta impresionante progresión.

Y hablando del R1 de DeepSeek, este modelo ha demostrado una capacidad de auto-mejora que roza lo futurista. Entrenado en desafíos de matemáticas y programación, su capacidad de razonamiento mejoró internamente. Esto no solo es un hito, sino que marca una nueva fase de autonomía en el aprendizaje de la IA. ¡El futuro es ahora!

Retos y Sinergias: La Combinación Óptima

Ahora bien, la implementación de RL no es un camino de rosas, presenta sus propios desafíos. Requiere un diseño meticuloso de la función de recompensa, una tarea digna de un maestro artesano. Y la complejidad se dispara en entornos del mundo real, donde los objetivos son tan dinámicos como impredecibles.

Aun así, la combinación de RL con el aprendizaje por imitación ofrece una sinergia explosiva. La imitación puede proporcionar un valioso punto de partida. Y el refuerzo, cual pulidor experto, refina el comportamiento, llevando el rendimiento a cotas superiores.

Este enfoque híbrido maximiza la eficiencia del entrenamiento como nunca antes. Esto se traduce en una reducción significativa de la necesidad de vastos conjuntos de datos de prueba y error iniciales.

La Explosión de Capacidades en LLMs

El giro estratégico hacia la post-formación,impulsado magistralmente por el aprendizaje por refuerzo,marcó un hito innegable en la historia de la IA. La inteligencia artificial,por fin,transita de la mera predicción a la resolución activa y genuina de problemas. Esta evolución, sin duda, redefine por completo el potencial de los sistemas autónomos.

La capacidad de la IA para aprender mediante ensayo y error es, en esencia, la pieza angular del progreso. Permite la creación de herramientas no solo más confiables, sino increíblemente versátiles. El resultado: una oleada de innovación sin precedentes en múltiples sectores.

El futuro de los LLMs se perfila en su habilidad para el razonamiento multifacético, un verdadero superpoder. Estos modelos continuarán transformando radicalmente la interacción humano-máquina. La integración de la inteligencia artificial en nuestra vida cotidiana se hará, sin duda, cada vez más profunda y omnipresente.

¿Qué aplicaciones de IA con razonamiento avanzado te parecen más prometedoras o incluso revolucionarias? ¡Queremos saber tu opinión en los comentarios!

¡No te quedes atrás! Sigue a Tendencias Digitales para estar siempre al día con lo último y más candente en tecnología y tendencias digitales. 🔥